ArcGIS Data Pipelines est une application Web facilitant le processus d’intégration de données externes à héberger. Elle offre un moyen rapide d’ingérer, préparer et conserver des données à des fins de cartographie, d’analyse, de création de rapports, etc. Dans ce pas-à-pas, vous découvrez les étapes de ce flux : l’accès aux sources de données, l’exploration et la transformation des données et enfin leur intégration dans vos contenus hébergés utilisables ensuite dans ArcGIS.

Pas-à-Pas réalisé par Raynald Garnier (Esri France), en partenariat avec le blog arcOrama.fr

Pas-à-Pas réalisé par Raynald Garnier (Esri France), en partenariat avec le blog arcOrama.fr

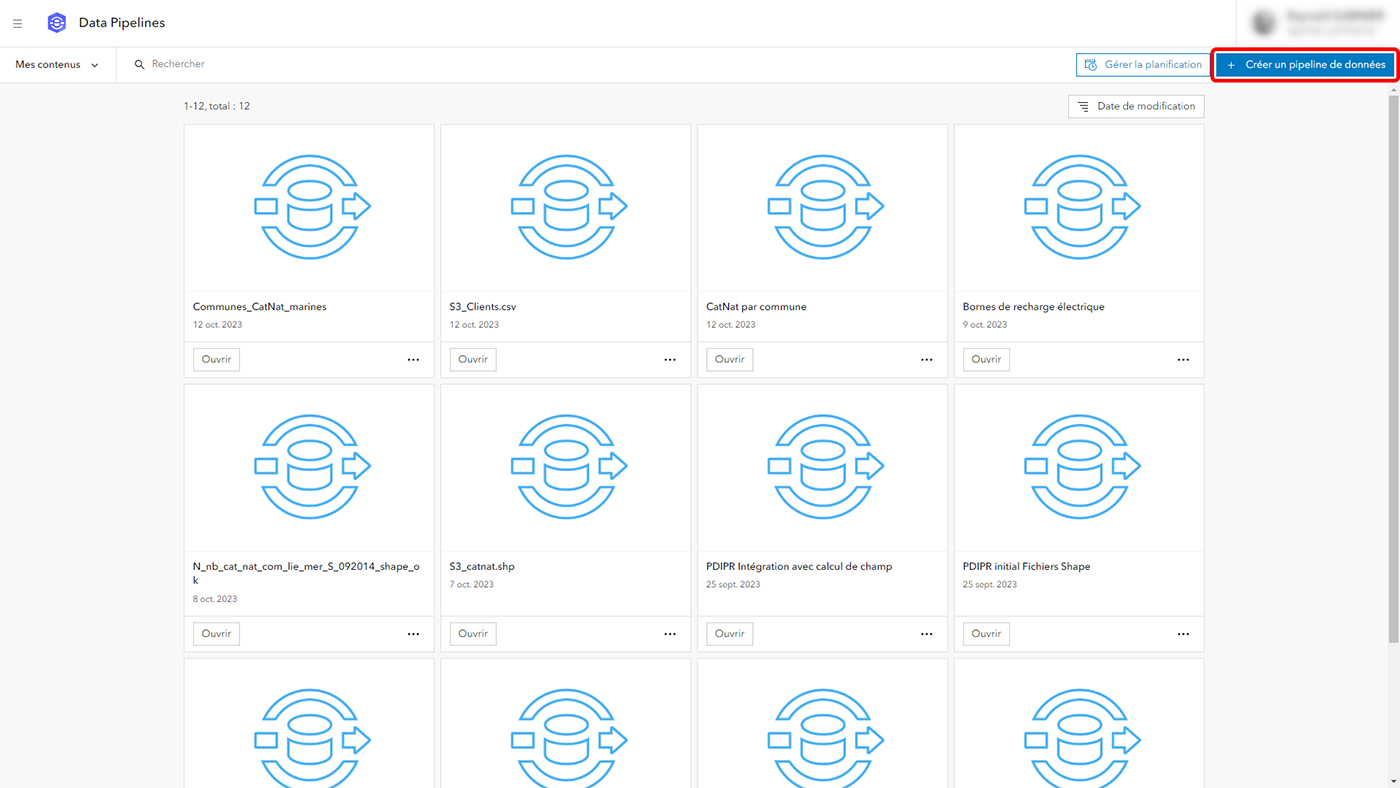

1- Pour accéder à ArcGIS Data Pipelines, vous devez disposer au minimum d’un type d’utilisateur Creator avec le rôle de publication. Après avoir lancé Data Pipelines depuis le lanceur d’applications d’ArcGIS Online, l’écran d’accueil de l’application vous propose de créer un pipeline de données, ou d’accéder aux pipelines de données existants pour les configurer, les exécuter ou gérer la planification de leur exécution automatique. Cliquez ici sur « Créer un pipeline de données ».

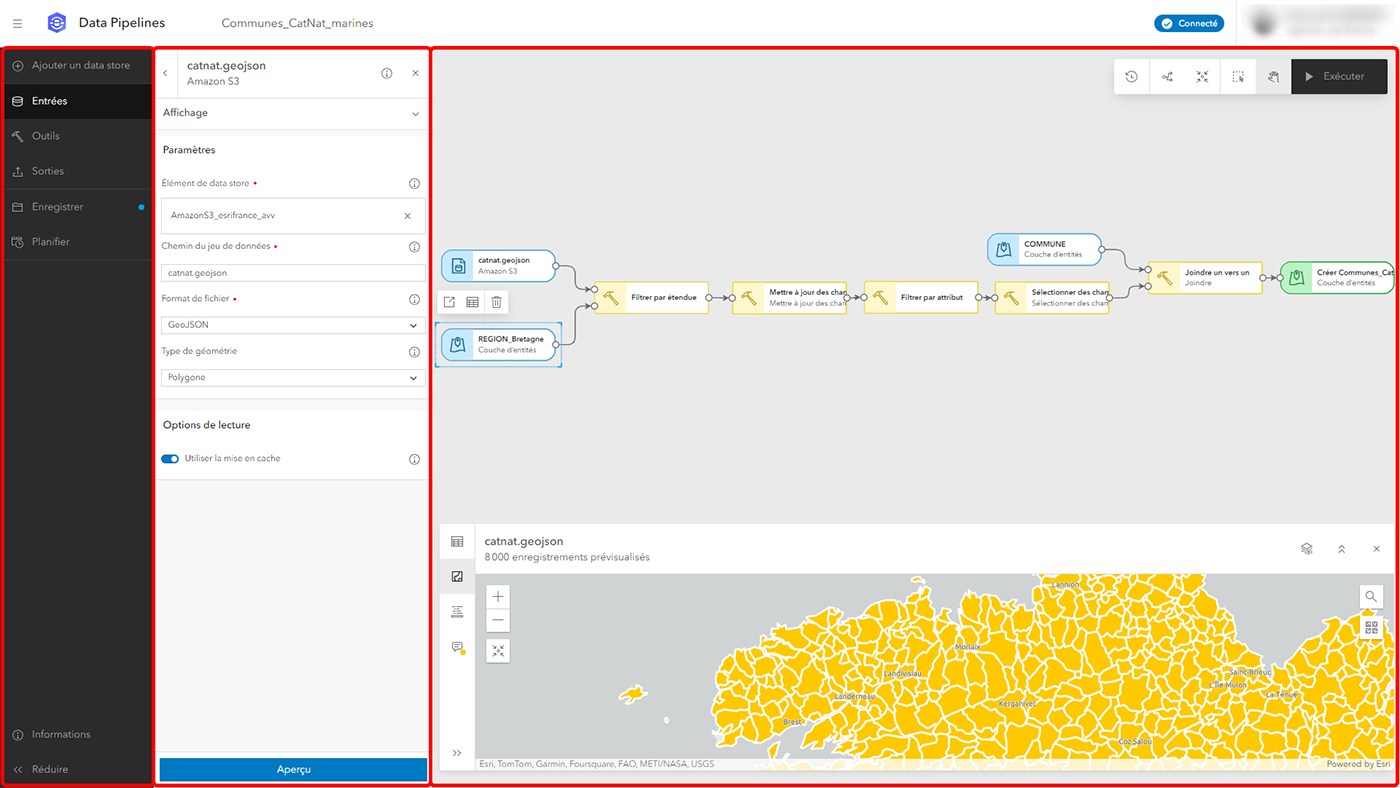

2- L’interface de Data Pipelines se compose de 3 parties : à gauche, une barre d’outils rassemble chacune des étapes du flux de travail, à côté s’affiche un volet de configuration de chacune de ces étapes, puis la zone centrale est dédiée à la visualisation interactive du pipeline de données et à l’aperçu des données connectées en cours de configuration (montrant une table, une carte ou la structure des données). Une fois le pipeline de données configuré, il peut être exécuté via le bouton en haut à droite.

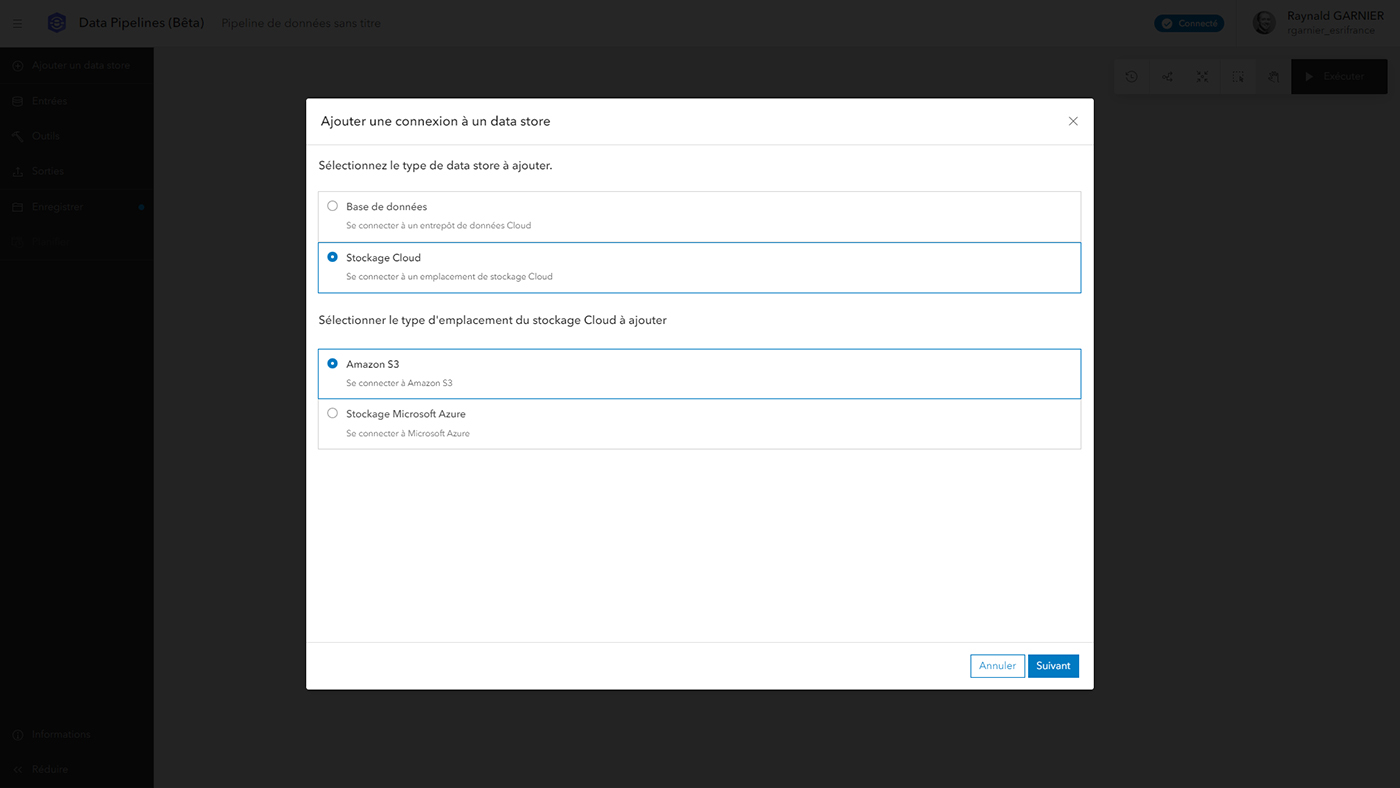

3- Si vous devez vous connecter aux sources de données hébergées dans le Cloud, telles que des bases de données (Big Query ou Snowflake) ou du stockage Cloud (Bucket Amazon S3 ou Blob Microsoft Azure), vous devez créer un data store. Si vous disposez d’autres sources de données de type URL publique, fichier ou couche d’entités hébergée sur votre portail ArcGIS Online, passez directement à l’étape 3. Sinon, cliquez sur « Ajouter un data store », choisissez son type, puis le type de base de données ou d’emplacement de stockage Cloud, et spécifiez les informations de connexion. Le data store créé sera hébergé en tant qu’élément du contenu ArcGIS Online, partageable et utilisable comme source de données en entrée dans plusieurs pipelines de données.

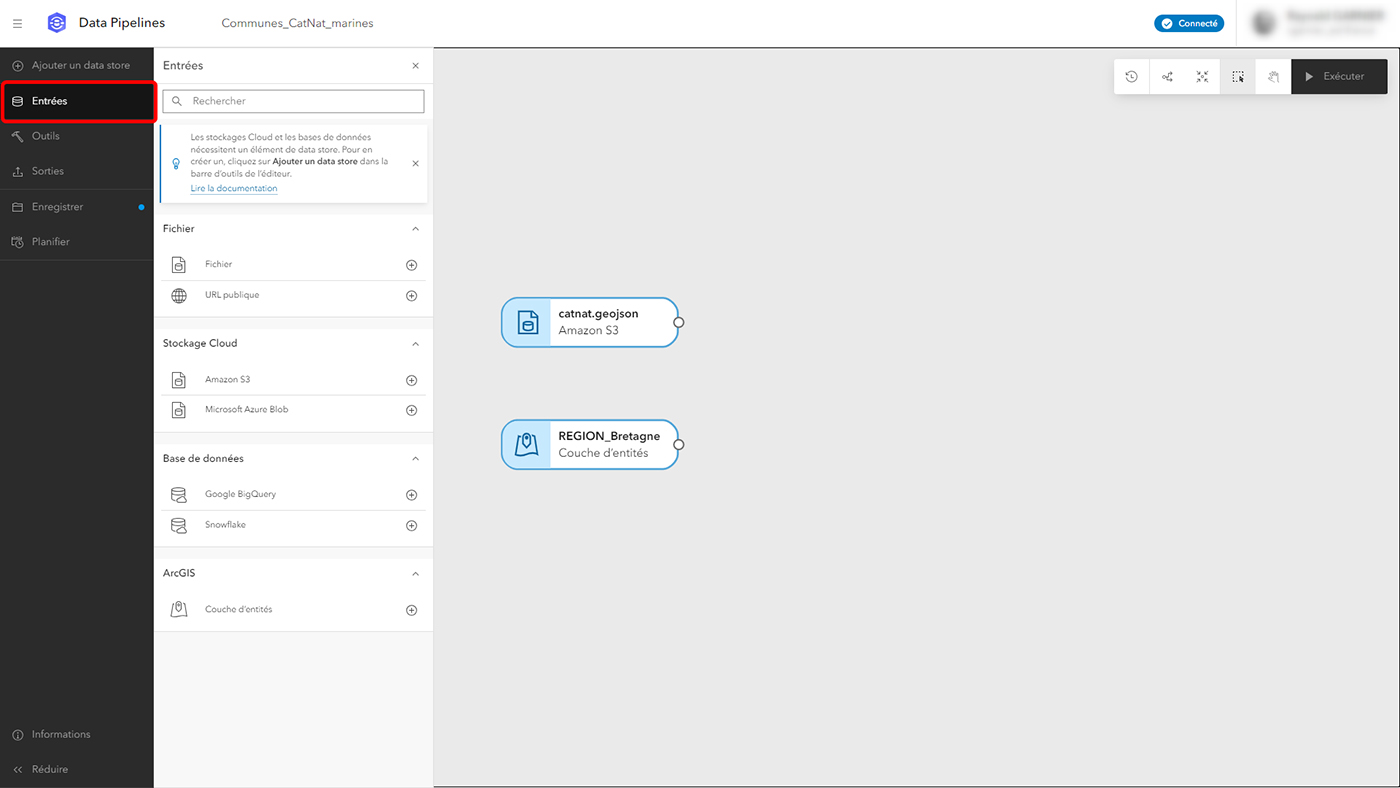

4- Quelle que soit son origine, toute source de donnée nécessaire peut être ajoutée via le bouton « Entrées ». Il peut s’agir d’une source Cloud déclarée en tant que data store, mais aussi d’un fichier local ou hébergé sur le portail, d’une URL publique pointant vers un fichier GeoJSON, JSON, CSV ou Parquet, ou bien une couche d’entités hébergée. Le pipeline de données peut utiliser une ou plusieurs sources en entrée, permettant d’effectuer des fusions ou des jointures. Ajoutez-en à chaque fois que nécessaire pour avancer dans votre flux d’intégration. Les sources ajoutées en entrée sont visibles au centre de l’écran.

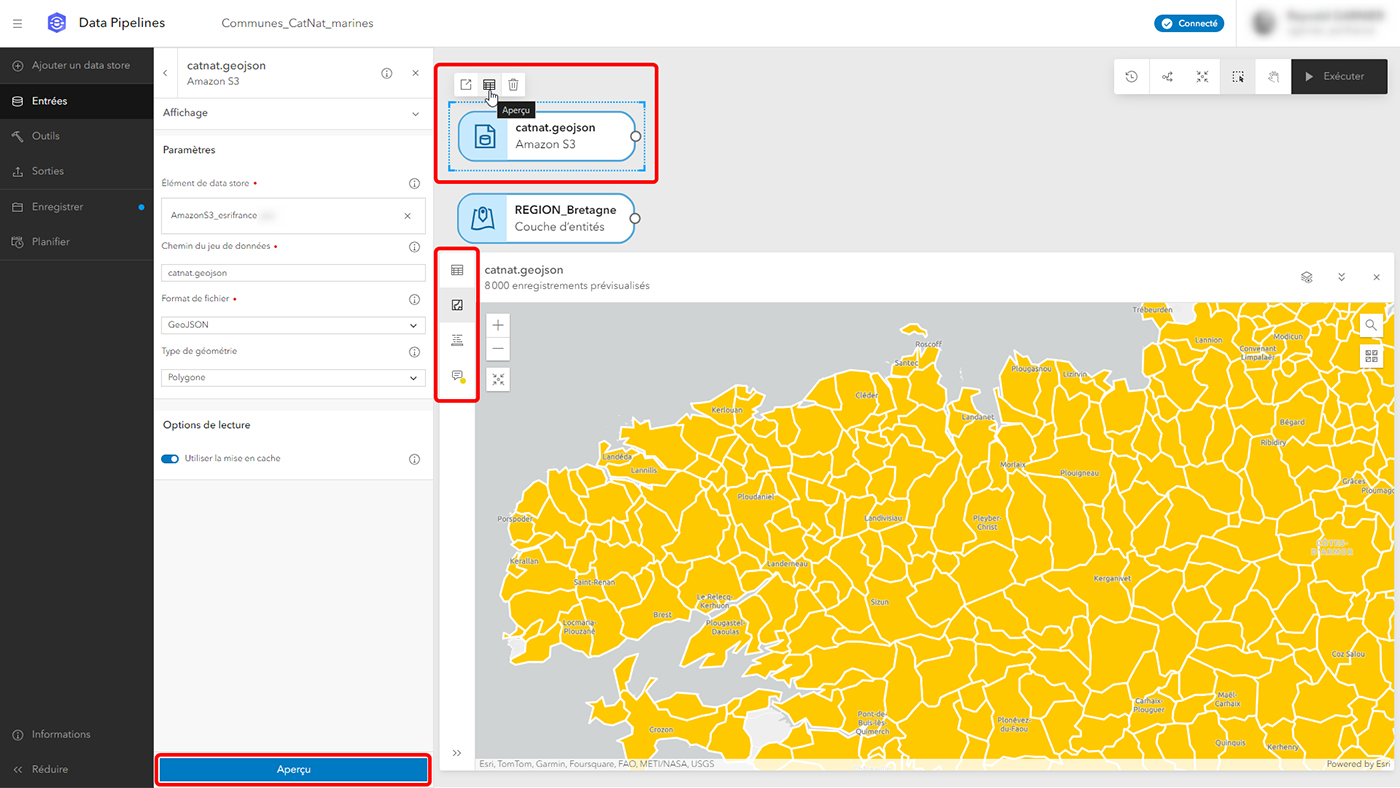

5- Chaque donnée ajoutée en entrée peut être visualisée en Aperçu, sous forme de table, de carte ou de modèle de données. Pour afficher l’aperçu, cliquez sur l’élément dans le modèle central puis sur l’icône de table, ou bien sur le bouton « Aperçu » depuis le volet de configuration. Changez ensuite de mode entre la table, la carte et le modèle de données. Ce volet d’aperçu est redimensionnable et peut également afficher les messages importants.

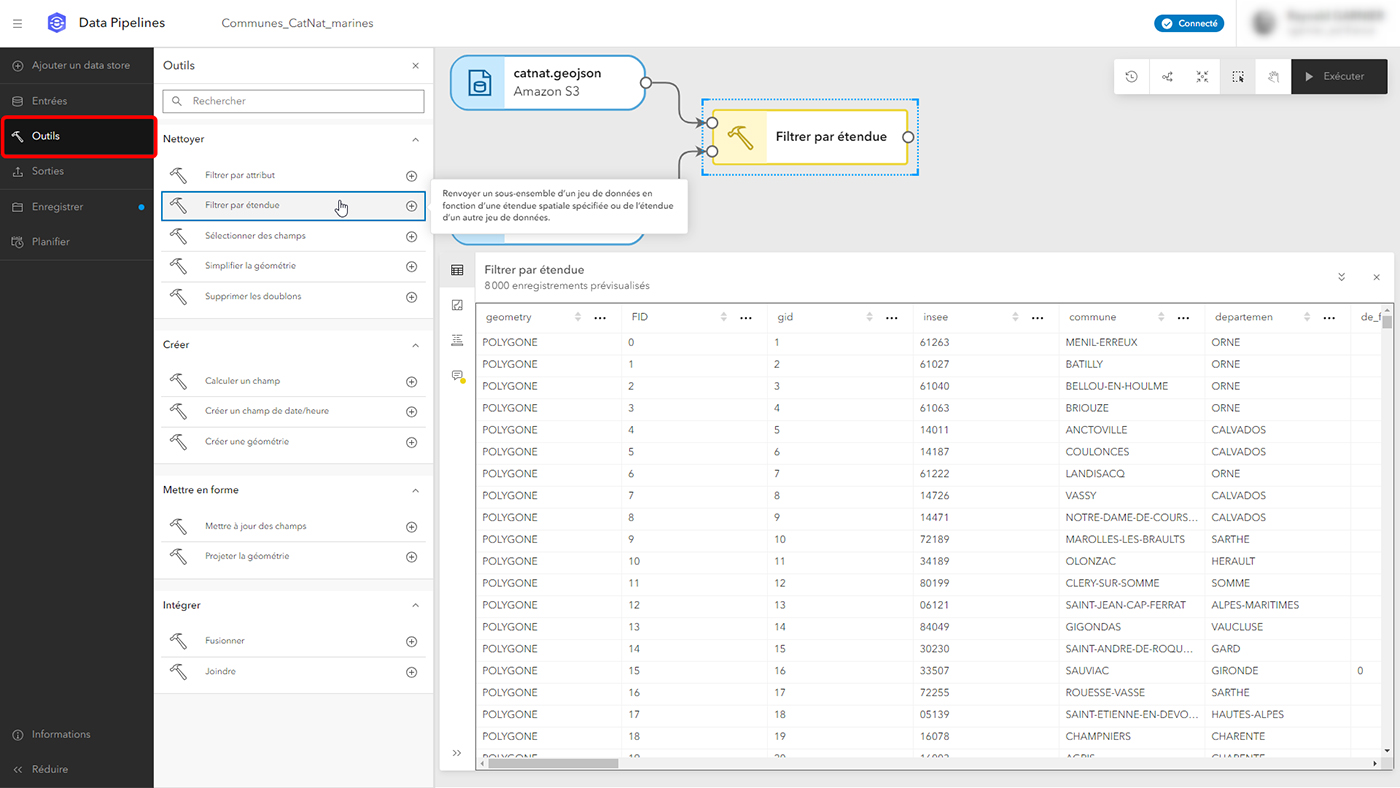

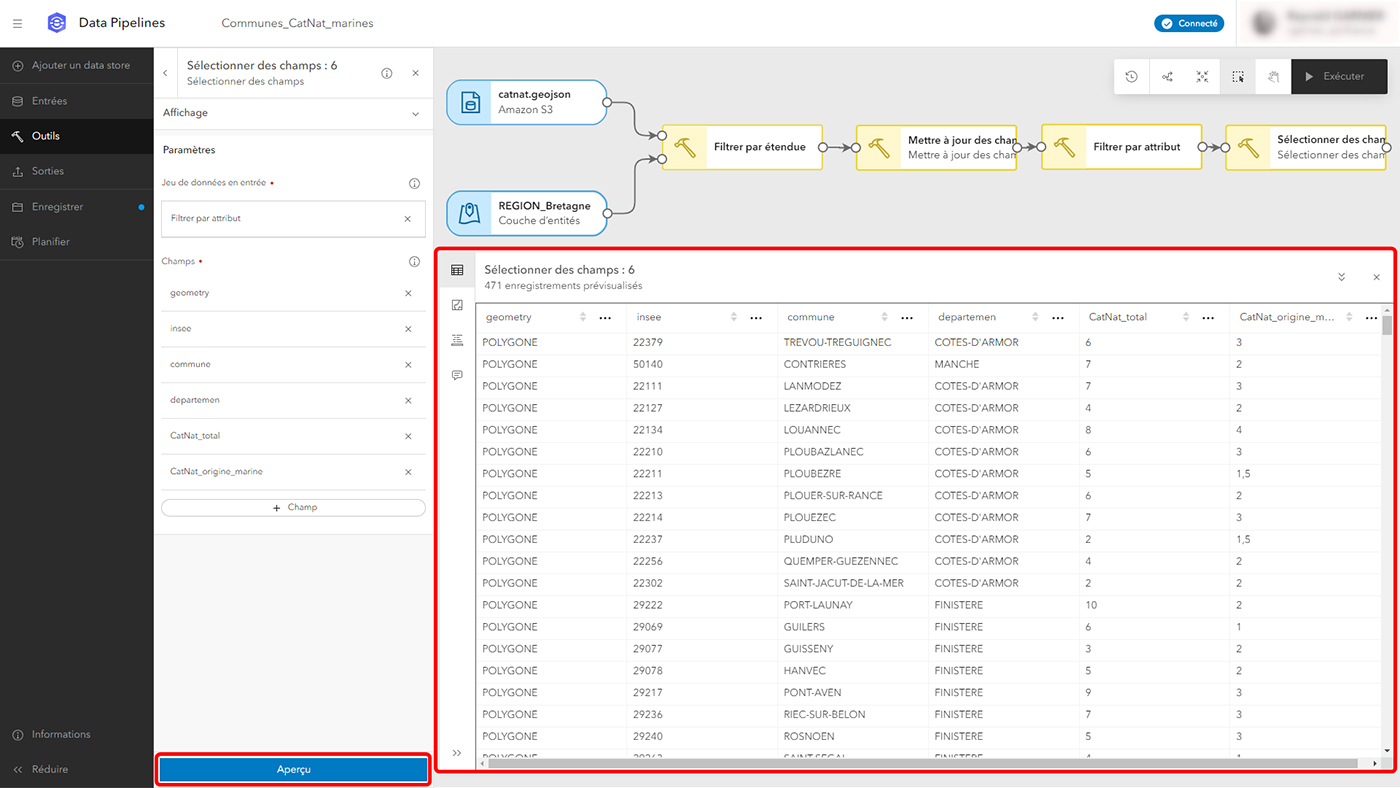

6- Vient ensuite l’étape d’utilisation des « Outils », s’ajoutant par simple glisser-déposer dans le modèle au centre de l’écran ou via le bouton (+), les éléments ajoutés s’associant en les reliant par des flèches, ou via l’assistant de configuration de gauche. Les outils sont rassemblés autour de quatre types d’opérations de Data Engineering : « Nettoyer », « Créer », « Mettre en forme » et « Intégrer ». Notez que la navigation dans le modèle est facilitée à l’aide des outils en haut à droite (sélection ou déplacement), mais aussi de raccourcis clavier (barre d’espace pour activer temporairement le déplacement depuis la sélection, touche CTRL+molette de la souris pour zoomer/dézoomer dans le modèle. Une fois l’outil ajouté et lié aux autres éléments, la configuration se poursuit jusqu’à l’aperçu du résultat.

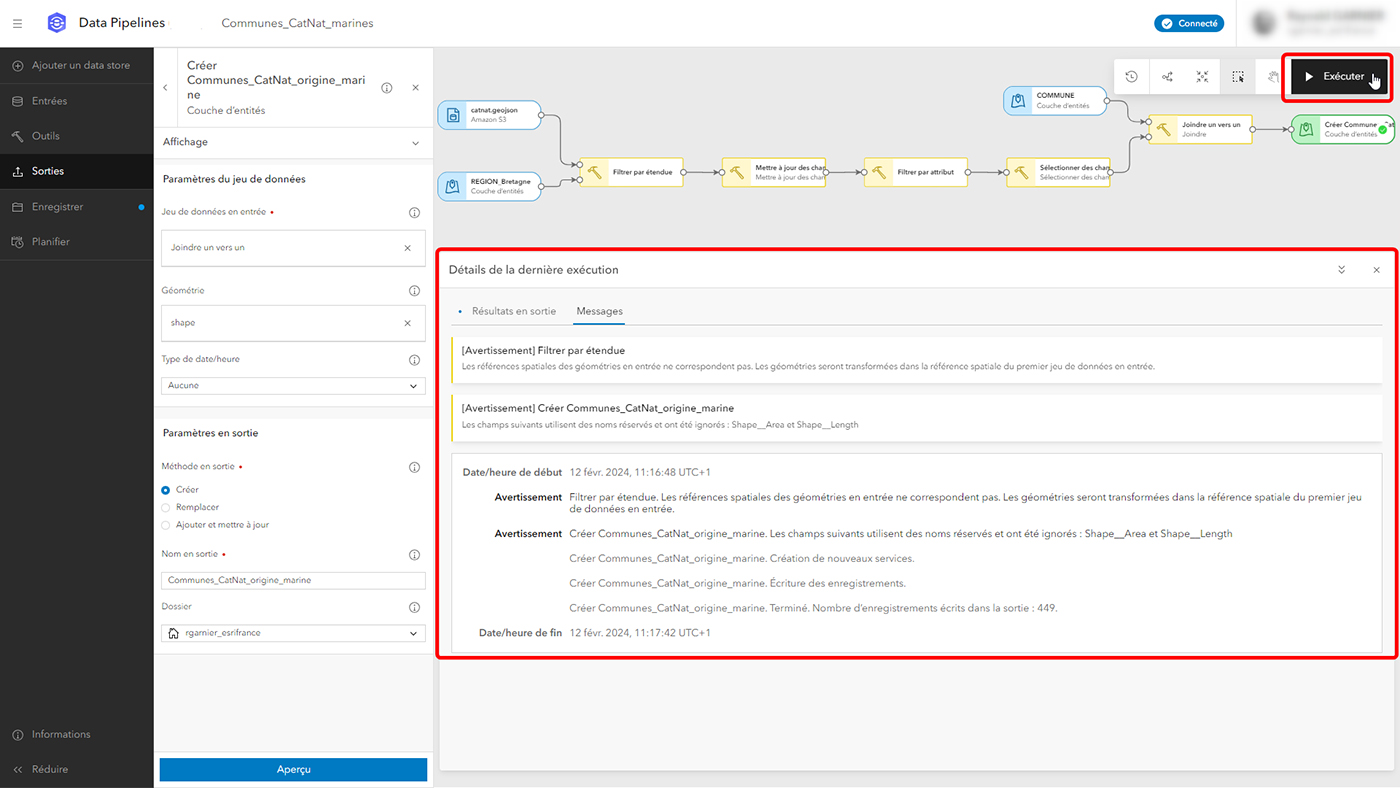

7- Chaque nouvel outil peut ainsi se succéder aux précédents et venir enrichir le processus de préparation des données utilisées en entrée, afin de réaliser toutes les opérations nécessaires, de filtrage, de sélection, de généralisation, de suppression des doublons, de calcul, de création de date/heure ou de géométrie, de mise à jour des champs ou de la projection, de fusion, de jointure, etc. À chaque nouvelle étape ajoutée via un outil, un nouvel aperçu des données est disponible et permet de valider les paramètres via la table, la carte ou le modèle de données. Pensez à surveiller le volet messages qui peut alerter parfois sur des avertissements ou des erreurs.

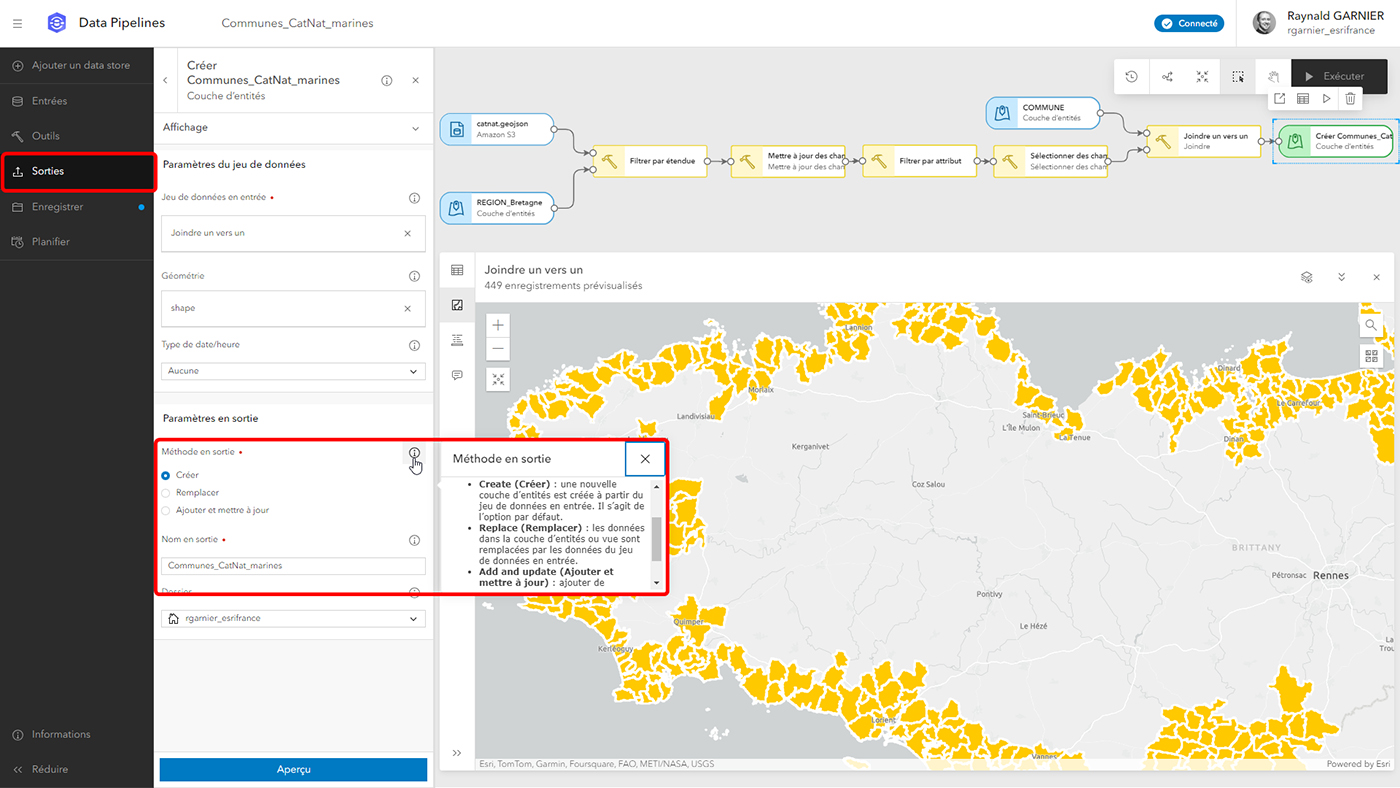

8- Une fois toutes ces étapes de Data Engineering réalisées et qui ont permis la préparation ou la modification des données d’entrée, il est temps de définir les données en sortie en cliquant sur le bouton « Sorties ». Un point important sur les capacités de génération des données en sortie est qu’il n’est pas forcément obligatoire de « Créer » systématiquement une nouvelle couche d’entités. En effet, il est également possible de « Remplacer » complètement les données d’une couche d’entités hébergée sur le portail ArcGIS Online, ou « d’Ajouter » et mettre à jour les enregistrements d’une couche d’entités existante.

9- Une fois les données en sortie configurées, il reste à exécuter le pipeline de données pour réaliser toutes les opérations liées aux outils utilisés et générer la couche d’entités qui sera hébergée ou mise à jour sur le portail. Le volet « Messages » affiche les éventuels avertissements ou erreurs, permet de suivre la progression de l’opération et informe lorsque l’exécution est terminée.

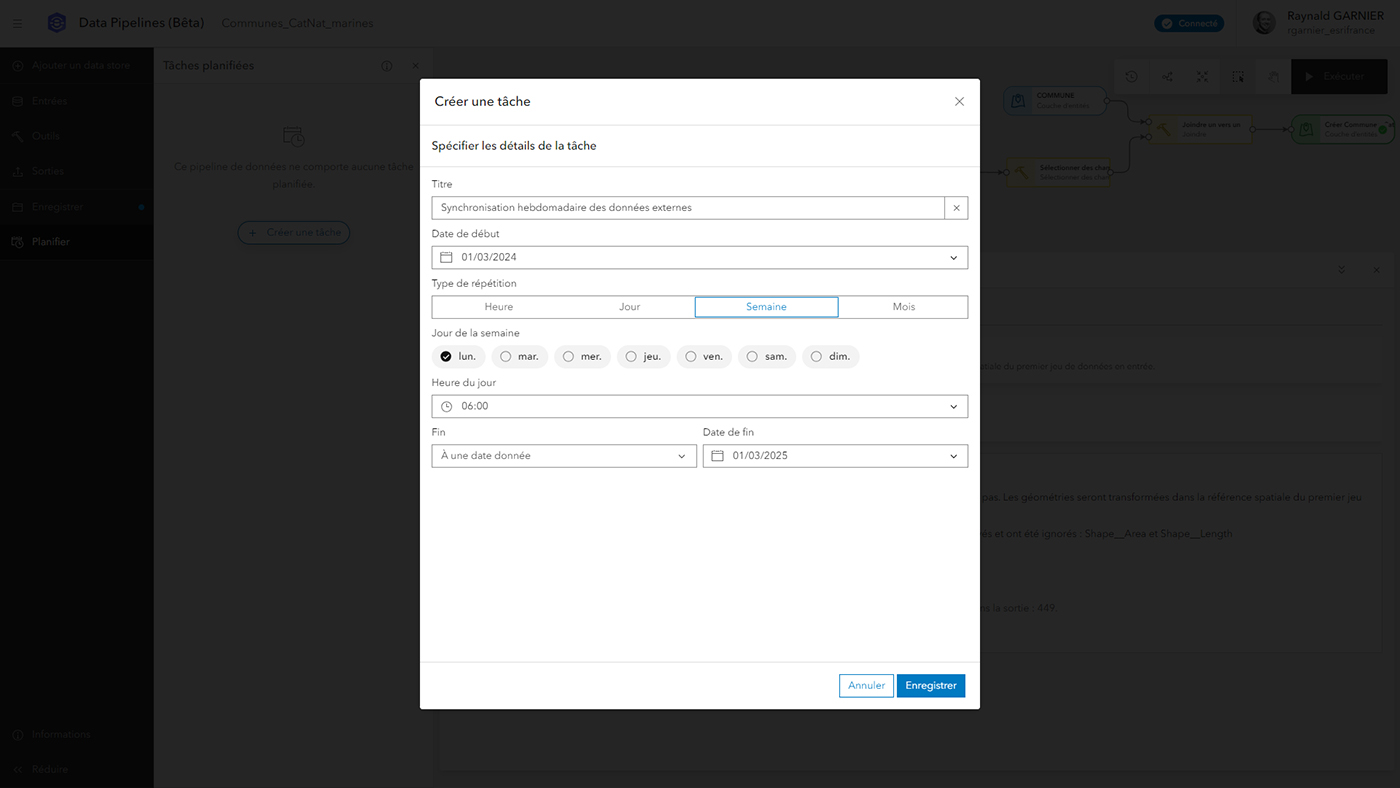

10- Tout pipeline de données peut être ainsi exécuté manuellement, mais son exécution peut également être automatisée via la planification. Cliquez sur le bouton « Planifier » à gauche de l’écran. Créez ensuite une tâche planifiée, avec un titre, une date de début, une fréquence de répétition, une fin ou non, puis enregistrez. La tâche planifiée sera ajoutée à une liste consultable depuis l’écran d’accueil de Data Pipelines, via le bouton « Gérer la planification ». Notez que l’utilisation de Data Pipelines consomme des crédits en mode interactif (via l’interface utilisateur) ou en exécution automatique (via la planification), pensez donc à considérer ce point selon le temps consacré à sa conception et son exécution en mode interactif, ou selon la fréquence d’exécution automatique planifiée.

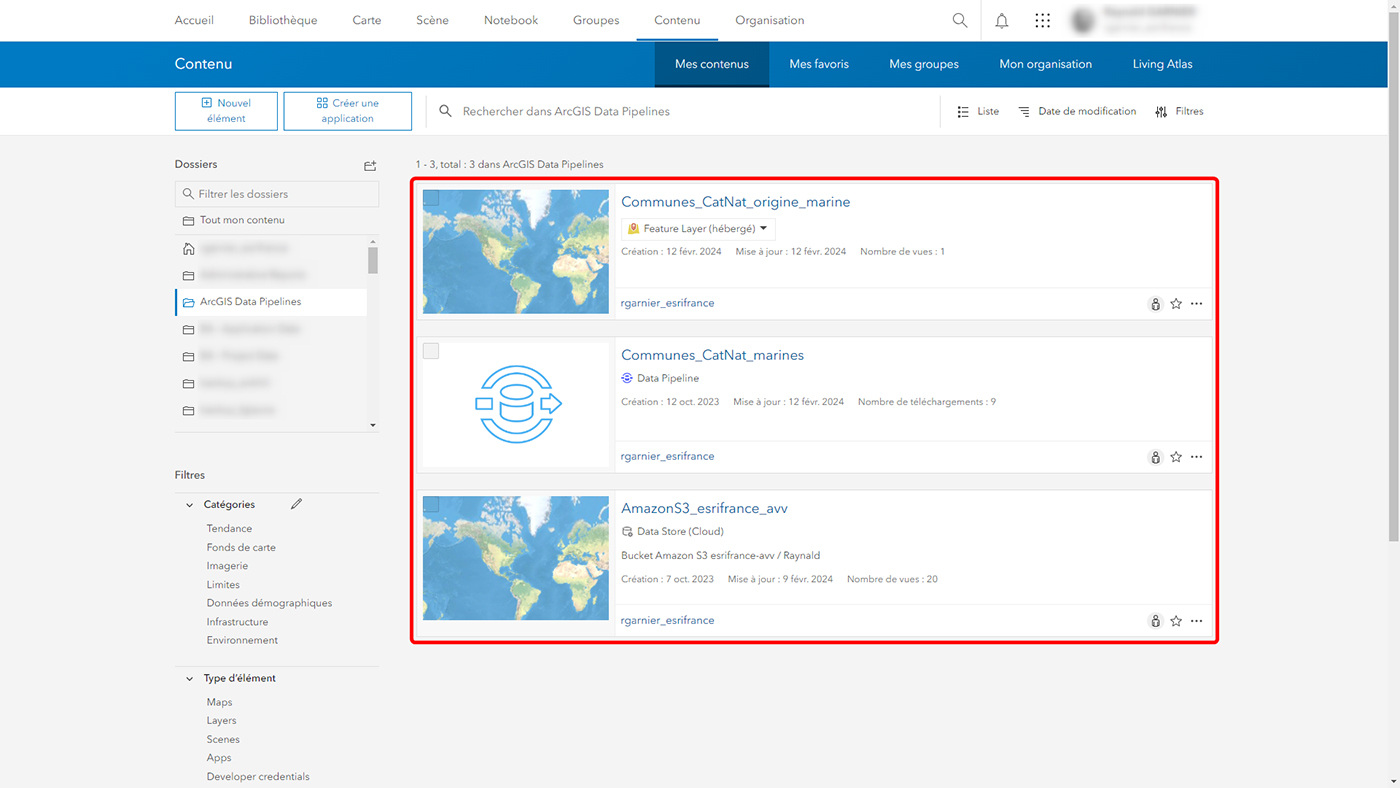

11- Les résultats de ce flux de travail dans Data Pipelines sont différents éléments créés et hébergés dans le contenu du portail ArcGIS : la ou les data sources définies au début du flux de travail, le pipeline de données que vous créez et enregistrez, et bien évidemment la couche d’entités hébergée générée en sortie à l’exécution du pipeline de données. Ainsi, vous pouvez en gérer le niveau de partage, les associer à des groupes et bien sûr les utiliser partout dans ArcGIS.

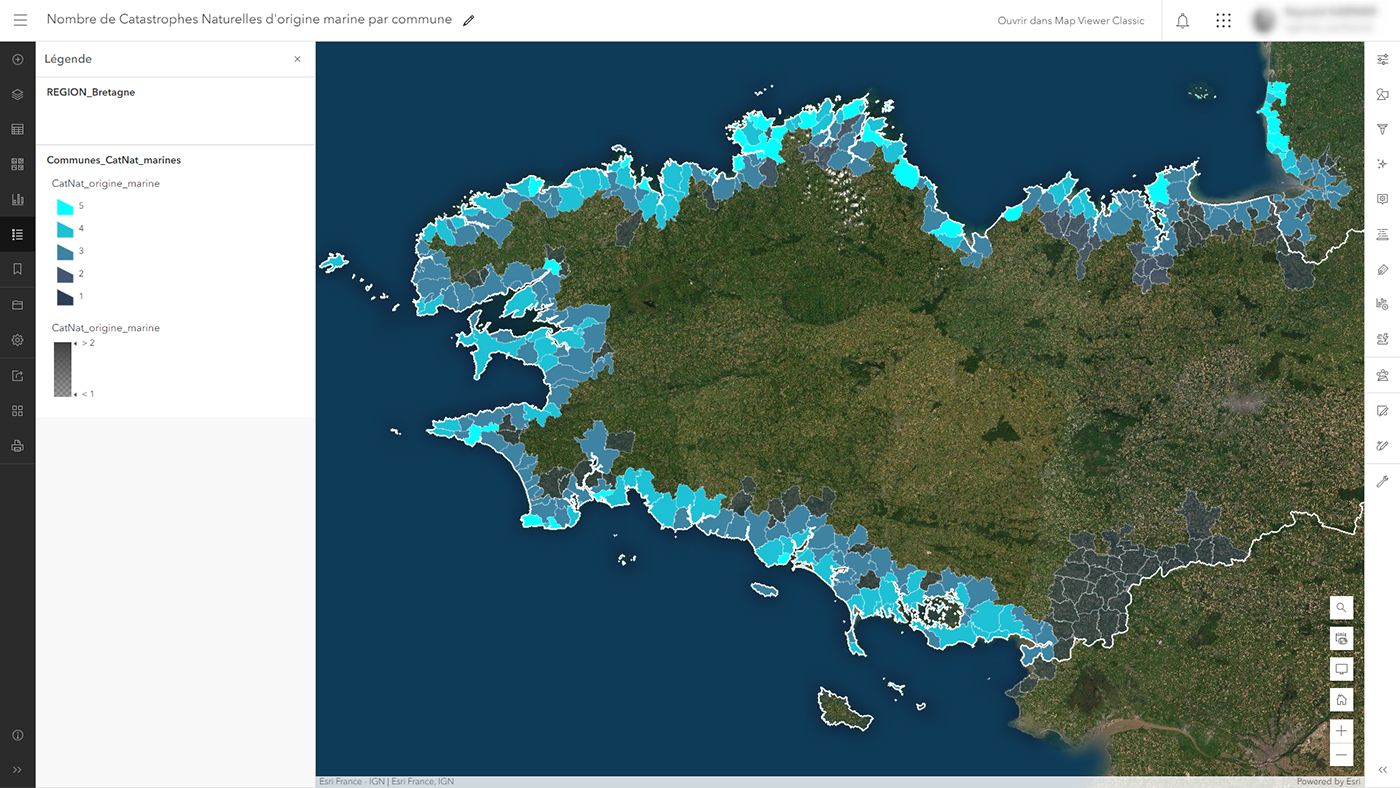

12- Les couches d’entités hébergées en sortie de l’utilisation de Data Pipelines sont ensuite exploitables dans vos cartes web comme illustré ici, vos scènes web ou vos applications du quotidien. Leur mise à jour automatisable permet ainsi d’exploiter de nombreuses sources externes de données (Cloud, Open Data, depuis votre Système d’Information…) dans tous vos flux de travail, qu’il s’agisse de consultation, d’analyse ou de collaboration.

Intégrer, préparer et héberger des données externes dans son SIG

Intégrer, préparer et héberger des données externes dans son SIG

L'essentiel

L'essentiel